摘要:技术变革深刻影响着开放科学(OS)实践,因为以透明、可获取和协作的方式开展科研,离不开支持合作与成果共享的工具和平台。这种内在关联决定了所采用技术的特性会直接影响OS的目标。生成式人工智能(GenAI)正在日益被研究者用于文本润色、代码生成/编辑、文献综述及数据整理/分析等任务。然而,其在开放性、透明度与偏见方面的表现表明,GenAI亟需加强与OS的融合。该技术虽能显著提升科研效率,但其现存缺陷可能对OS的核心价值(如公平性、透明度和科研诚信)产生负面影响,并损害不同社会群体的利益。本文结合国教科文组织(UNESCO)《开放科学建议书》的分类框架,系统探讨GenAI与OS的相互作用。研究认为:GenAI有望通过拓展知识获取途径、提升基础设施利用效率、促进社会主体参与、加强知识体系间的对话来推动OS目标;但由于其技术局限性,也可能危及研究的完整性、公平性、可重复性与可靠性。因此,在科研流程中引入GenAI时,必须建立充分的核查、验证与批判性评估机制。

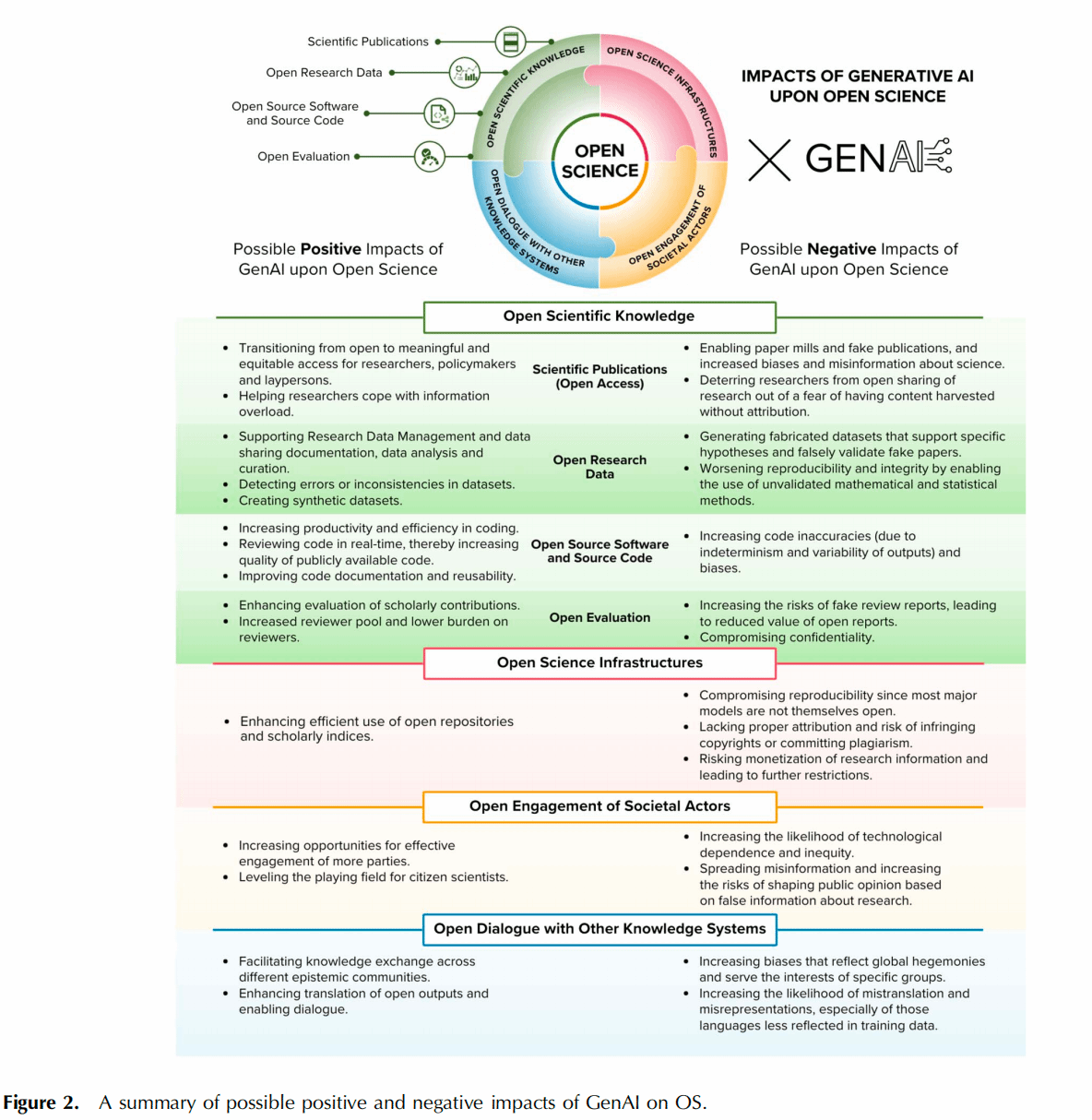

GenAI对OS同时具有潜在正向与负向影响(见图2)。

在探讨这些影响时,存在三个关键议题:一是与所谓“有意义的获取”相关。OS运动长期致力于推动研究成果与材料的开放获取,包括开放获取论文和开放数据。然而,这些成果往往未能以公众可理解或有效参与的形式呈现。虽然GenAI能够促进有意义且公平的获取,但它并非无风险——这种使用创造了一种认知依赖,许多用户可能无法批判性地验证GenAI的输出,同时还面临着有意或战略性滥用学术内容的风险。由GenAI带来的错误信息或虚假信息的产生和传播风险,构成了第二个反复出现的议题。三是学术研究的多样性与包容性受到影响。GenAI通过提升对学术成果的实质获取能力、增强研究过程参与度,可能促进学术生态包容性与主体多元化。但需警惕的是,其模型机制与训练数据中固有的偏见可能强化特定世界观,最终阻碍OS多元价值的实现。

当前学界对改革研究与研究者评估体系存在迫切需求。对现有评估方式(如过度依赖片面指标、对学术价值认知狭隘)的不满,已推动多项改革倡议:包括《旧金山科研评估宣言》、推进研究评估联盟(CoARA)及《巴塞罗那开放研究信息宣言》等。这些倡议倡导负责任评估及支持该目标的OS实践。

GenAI可从以下维度助力这些目标:首先,通过更精准识别和关联多元化研究成果(如数据与软件),并完善元数据标注,GenAI可提升成果的可发现性与关联性,尽管当前仍存在关联可靠性风险。其次,多模态GenAI能整合多类型数据并生成洞察,有助于全面呈现学术贡献的广度,深化对知识转化过程的理解。再者,GenAI在数据与代码的自动检测、质量评估及代码审查方面具备潜力,可凸显研究中产生的各类成果(如软件工具)。此外,本地部署的GenAI系统可在进度报告、叙事性简历及学术稿件评议中发挥作用:通过初步筛选、内容摘要与主题识别辅助评估工作。这种机制符合开放评估的核心目标,确保研究者或项目的关键成果得到充分认知与认可。

对于OS支柱之一的开放同行评议,GenAI具有特殊意义。开放同行评议通常涵盖开放报告(评审意见与论文同步公开)、开放身份(公开评审人信息)及开放参与(吸纳非受邀评审人)三大维度。正如前文所述,GenAI能通过降低参与门槛,促进患者、研究参与者及其他非学术群体加入评审,显著增强开放参与维度。尽管传统期刊严格限制其使用,但在预印本后评议等受监管较少的场景中,GenAI正成为扩大评审群体多样性的有效工具。因此,在开放同行评议层面,GenAI最核心的积极价值在于推动更包容、更公平的学术参与生态。

相比之下,GenAI对开放评议报告的潜在影响同样值得警惕。开放评议报告本被认为是防范掠夺性期刊的有效手段,并为同行评议的元研究提供了可能。然而,GenAI能快速生成表面可信却缺乏实质内容的评审意见,若被恶意用于伪造评议报告,反而会助长掠夺性期刊的合法性。这意味着,仅公开评议报告已不足以证明实质性的同行评议确实发生。

为确保评审真实性,需辅以额外机制,例如建立开放身份体系,明确评审人信息与评审时间。但该机制本身也存在尚未充分研究的负面影响,如评审人可能因提出批判性意见而遭受报复,这对处于弱势地位的学者(如早期研究人员或少数群体成员)影响尤甚,反而可能削弱评审群体的多样性,抵消前节所述的积极效益。

此外,如前所述,多家资助机构与出版商出于保密性考虑,已限制将GenAI用于评审与评估工作,这对未公开成果或进行中的项目(如基金申请)尤为重要。尽管通过本地化部署可在一定程度上规避数据泄露风险,但该方案成本高昂、资源密集,仅适合大规模且无需外部信息的评估场景,难以被个体评审人或资源有限的机构公平采用。

需强调的是,无论采用云端或本地GenAI分析研究成果与进展报告,均需获得相关机构与研究者的明确授权,并建立人工审核机制以确保评估准确性与责任归属。目前,相应的基础设施与操作指南仍处于缺失状态。

GenAI通过大量使用开放获取文献、开放数据与开放代码等OS成果作为训练数据,部分实现了早期开放数据运动中将数据喻为"新石油"的愿景。但如前所述,其封闭的商业模式、资源密集型开发特性,以及潜在的偏见与错误问题,都对将这类工具纳入OS工作流提出了根本性质疑。

GenAI的资源密集性体现在多个维度:海量训练数据需求、高昂的模型训练与运行成本、专业使用门槛,以及巨大的生态足迹。这些因素共同制约了工具获取的公平性,影响使用的多样性与包容性。随着技术垄断格局的形成,大型开发商可能进一步强化其优势地位,若封闭私有模型成为OS核心基础设施,将加剧既有的排斥效应与优势累积现象。

面对显著的环境与经济代价,研究者需审慎评估:GenAI是否是实现科学开放的最优路径?是否存在成本更低、环境可持续性更强的替代方案?在当前技术探索阶段,必须结合成本、能力与风险进行综合权衡,持续反思其应用的必要性。

关于模型开源路径的争论已成为核心议题。2023年英国全球人工智能安全峰会上,开源问题形成明显分歧:一方强调开放模型可能引发滥用风险,另一方则坚持开源是确保模型透明度、可解释性与公平性的基础。为契合OS强调透明、可及与包容的核心精神,建议科研界应优先选择开源模型,这既是推进技术民主化的关键,也是维护OS价值观的必然要求。

GenAI在推动OS发展的同时,也伴随着必须应对的重大风险与挑战,二者存在复杂的相互作用。呼吁相关科研界携手开展研究并应对这些问题,确保GenAI为科学共同体、全社会及两者间的良性互动创造积极价值。需明确指出,若未经核验而过度依赖GenAI的输出结果,可能损害研究的诚信、公平性、多样性、可重复性与可靠性。因此,将GenAI纳入科研工作流时,必须建立充分的核查、验证与批判性评估机制。主张应以开放原则统领GenAI的治理体系,将开放理念重新注入技术内核。过去数十年来,OS运动已建立起一套能够促进GenAI负责任发展的基础设施与规范体系。科研界应秉持公平、透明、可获取及参与式治理等OS核心价值,以此确保技术红利得以公平分配,并对这一即将成为关键科研基础设施的工具实施负责任治理。为实现此目标,优先采用符合OS价值观的GenAI模型(如公开披露训练数据来源的模型),将有效推动开发者以更实质性的方式践行OS理念。

开放科学环境下,研究者应在使用GenAI前做到:

对工具进行充分测试并建立防护机制,识别并降低其在相关语境中的偏见、错误或随机性风险,以保护相关方权益并维护科学公信力;

以审慎态度评估其资源密集特性,确认其为特定场景下的最优且可持续解决方案;

优先选用开源模型以契合OS原则,最大程度保障公平性、可解释性、透明度与可重复性;

明确自身对GenAI输出结果的主体责任,在使用时进行规范引用(建议包含模型版本、使用时间、提示词设计及有效性检验等信息),以便公开监测模型表现及其对知识生产的影响。

鉴于GenAI对OS的影响,机构、资助方、出版商等知识生产参与方应当:

提供系统培训与公开指南,明晰特定GenAI模型的优势与局限;

结合自身情境持续监测GenAI对OS的双向影响(参见上图);

定期公开其使用GenAI的情况与产出,特别是在贡献开放知识、数据或基础设施时;

探索GenAI在拓展成果识别与关联维度(如数据、软件)方面的评估潜力,及其在进度报告、叙事性简历和手稿评审中的辅助作用,该过程需注重敏感数据保护、优先采用本地化部署,并警惕内在偏见与随机错误;

确保所有评估辅助应用均获得被评估方授权、符合数据保护规范,并设置充分的监督机制;

监测并遏制GenAI可能加剧的认识论霸权及科学知识解读中的偏见固化效应。

面对GenAI为OS工作流带来的机遇与风险,科研界需共同审视:

(全文及参考文献见Quantitative Science Studies 2025年第6期,原文链接:https://doi.org/10.1162/qss_a_00337,本期推文为节选摘编,略有删减和编辑。)

本期策划 | 复旦大学国家智能评价与治理实验基地

供稿 | 宋欣雨 王译晗

本期编辑 | 宋欣雨

基地官网:https://statevalbase.fudan.edu.cn

· end ·